Le climat de la Terre résulte principalement de trois facteurs : l’énergie solaire, l’effet de serre et les circulations atmosphériques et océaniques. N’en déplaise aux afficionados de la théorie du complot, la répartition géographique et saisonnière de l’énergie solaire dépend, quant à elle, de la rotondité de la Terre, de l’inclinaison de son axe de rotation et de son orbite autour du Soleil. Les différentes aires climatiques en sont la traduction ; elles conditionnent la répartition de la vie sur Terre.

L’effet de serre

Le Soleil est l’étoile centrale de notre système solaire. A sa « surface », la température est d’environ 6000° Celsius. Ni trop proche, ni trop éloignée du Soleil, la Terre est à une température moyenne de surface de 15°C qui permet la présence d’eau liquide. L’énergie solaire et la présence d’une atmosphère sont les deux éléments qui conditionnent cette température.

Comme les vitres d’une serre, certains gaz présents naturellement dans l’atmosphère, notamment la vapeur d’eau et le gaz carbonique, entravent l’évacuation de chaleur d’origine solaire et permettent d’obtenir cette température clémente de 15°C. C’est le phénomène de l’effet de serre naturel. Sans cet effet de serre, la température à la surface de la Terre serait de -18°C et la vie, si elle s’y avérait possible, serait fort différente.

En fait, les océans et les sols captent seulement la moitié du rayonnement solaire. 30% des rayons sont directement réfléchis par les nuages et le reste est capté par des gaz présents naturellement dans l’atmosphère. Ce système d’absorption du rayonnement solaire réchauffe l’atmosphère et, surtout, la surface de la Terre.

En retour, l’atmosphère et la surface de la Terre vont évacuer cette énergie, convertie en chaleur, en direction de l’espace. Cette évacuation de chaleur se fait sous forme de rayonnement infrarouge moyen. Une partie de ce rayonnement infrarouge terrestre (10%) s’échappe directement vers l’espace, les 90% restants sont captés par les gaz à effet de serre présents naturellement dans l’atmosphère. Ces gaz à effet de serre, principalement vapeur d’eau et gaz carbonique, ayant capté de la chaleur d’origine solaire et de la chaleur montant de la surface du globe, réémettent cette énergie sous forme de rayonnement infrarouge. Une partie de ce rayonnement, les 2/3, retourne vers le sol, le chauffant donc une deuxième fois, après que le Soleil l’a déjà fait une première fois. Le tiers restant s’échappe vers l’espace.

D’autres phénomènes contribuent à ce résultat. L’évaporation de l’eau liquide à la surface de la Terre qui est à l’origine de la formation des nuages tient un rôle important dans l’équation du réchauffement de l’atmosphère, et de plus, elle joue un rôle essentiel dans le cycle de l’eau. C’est cet échange constant entre la surface de la Terre et les gaz à effet de serre qui permet à la Terre de bénéficier d’une température moyenne de +15°C. L’effet de serre naturel de notre atmosphère est donc un phénomène bénéfique sans lequel la vie telle que nous la connaissons n’aurait pas été possible.

L’ozone

La couche d’ozone exerce son effet protecteur sur la vie sur Terre en limitant son exposition aux rayons ultraviolets.

Depuis les années 1980, la couche d’ozone stratosphérique est surveillée de près. Car pendant des années, des produits chimiques présents dans les aérosols, climatiseurs et autres réfrigérateurs – des chlorofluorocarbures et des hydrochlorofluorocarbures – l’ont mise à mal. Y creusant un trou béant. En 1987, le protocole de Montréal a interdit l’usage des principaux produits responsables de ce trou dans la couche d’ozone. Et les bienfaits de cette interdiction n’ont pas tardé à se faire sentir.

Aujourd’hui, un rapport d’experts mandatés par les Nations unies se montre particulièrement optimiste. Depuis 2000, la couche d’ozone s’est reconstituée à un rythme de 1 à 3 % par décennie. De quoi espérer revenir au niveau des années 1980 dès la décennie 2030 concernant l’hémisphère Nord. Plutôt dans les années 2050 pour l’hémisphère Sud et une dizaine d’années plus tard du côté des régions polaires.

Le protocole de Montréal, l’action mondiale la plus réussie ?

Certains sont déjà prêts à qualifier le protocole de Montréal d’action mondiale en faveur de la protection de l’environnement la plus réussie de l’histoire. « Mais il ne faut pas crier victoire trop vite », mettent en garde les scientifiques. Des études récentes rapportent en effet une augmentation inquiétante des concentrations atmosphériques de CFC-11, l’une des substances interdites par le protocole.

Les experts remarquent par ailleurs que le rétablissement de la couche d’ozone au-dessus de l’Antarctique pourrait y aggraver les effets du changement climatique.

Ceci dit, depuis quelques années, des doutes subsistent, notamment parce qu’en 2015, la lente diminution du trou de la couche d’ozone observée depuis une décennie environ semblait s’inverser. Jusque-là, les mesures suggéraient que depuis 2000 le trou de la couche d’ozone avait diminué d’environ 4 millions de kilomètres carrés soit plus que la surface de l’Inde.

Les gaz à effet de serre

Le principal gaz à effet de serre (GES) naturel est la vapeur d’eau. Elle contribue pour moitié à l’effet de serre naturel. L’autre GES naturel important est le gaz carbonique qui contribue au quart de l’effet de serre naturel. Le gaz carbonique représente pourtant seulement 0,03 % des molécules composant l’air. D’autres gaz, le méthane, le protoxyde d’azote, l’ozone, participent également à l’effet de serre naturel, mais de façon plus faible. Les activités humaines rejettent d’importantes quantités de gaz à effet de serre dans l’atmosphère. Ces gaz d’origine anthropique sont très probablement responsables des tendances climatiques observées depuis 1975. Ces gaz sont principalement :

- le gaz carbonique (CO2) qui provient en majorité de la combustion des énergies fossiles (pétrole, charbon, gaz naturel) utilisée pour les transports et le chauffage et, d’une façon moindre, de la déforestation;

- le méthane (CH4) abondant dans les zones humides naturelles ou anthropiques telles les rizières, également issu de la digestion des ruminants, des décharges et des pertes lors de l’extraction, du transport et de l’utilisation du gaz naturel ;

- le protoxyde d’azote (N2O) qui entre dans la composition des engrais ;

- les halocarbures, dont les célèbres CFC, qui n’existent pas à l’état naturel pour la plupart. L’industrie les a longtemps utilisés pour fabriquer certains produits, ou comme gaz réfrigérants ou propulseurs.

Le temps de présence d’un gaz dans l’atmosphère est appelé « temps de résidence ». La vapeur d’eau reste seulement quelques jours dans l’atmosphère. Mais la majorité des gaz à effet de serre reste bien plus longtemps : d’une décennie pour le méthane jusqu’à des milliers d’années pour certains halocarbures.

Le dérèglement climatique

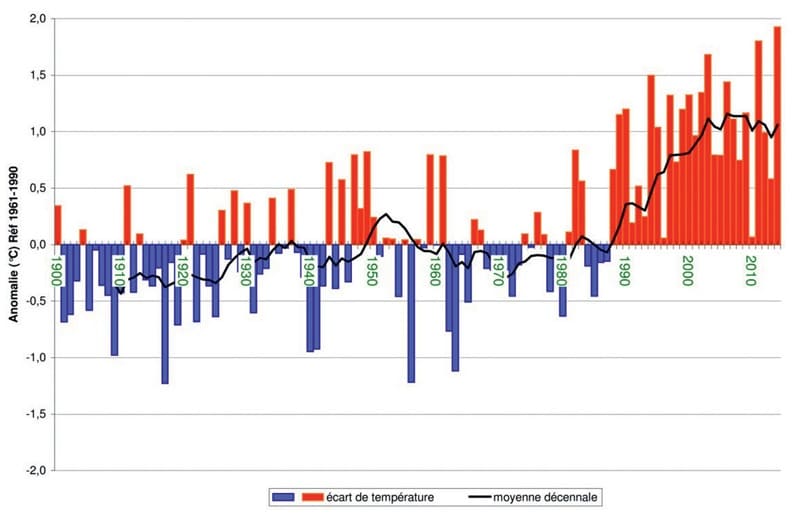

En intégrant graphiquement les mesures de températures dans presque tous les pays du Globe entre 1900 et 2016, les scientifiques ont montré de façon saisissante l’augmentation du nombre d’« anomalies de température », donc des écarts par rapport à une moyenne. On constate qu’en un peu plus d’un siècle, la proportion vire au rouge.

À ce jour, de nombreux experts attribuent au réchauffement, la fonte estivale de plus en plus importante des glaces situées aux pôles et en altitude, la montée du niveau des océans (à la suite de l’arrivée d’eau douce et par dilatation thermique des masses d’eau), ainsi que leur acidification.

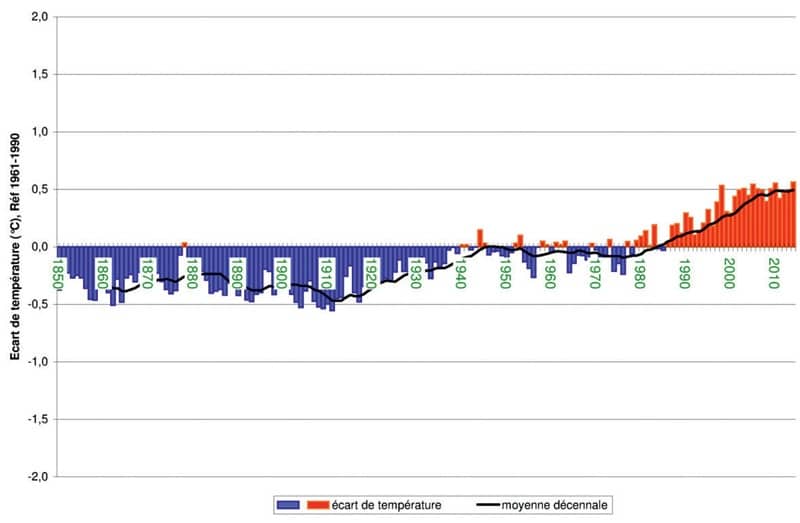

En France, depuis 1850, on constate une tendance claire au réchauffement, et même une accélération de celui-ci. Au XXe siècle, la température moyenne du globe a augmenté d’environ 0,6 °C et celle de la France métropolitaine de plus de 1°C.

Depuis au moins deux millions d’années, le climat de la Terre varie entre glaciaire et interglaciaire avec une quasi-périodicité d’environ 100 000 ans. Le dernier maximum glaciaire a eu lieu il y a 21 000 ans. À cette époque, la température de la Terre n’était que de 4°C à 7°C inférieure à sa valeur actuelle, et pourtant le niveau de l’océan était plus bas de quelques 120 mètres. L’Amérique du Nord et l’Eurasie étaient recouvertes d’une couche de glace qui atteignait 1 à 2 km d’épaisseur et s’étendait jusqu’à New-York et au nord de l’Allemagne.

La dernière déglaciation, entamée il y a 20 000 ans, s’est révélée climatiquement très favorable à notre espèce. Dans des conditions relativement stationnaires, propices au développement de l’agriculture et de l’élevage, les hommes ont pu croître et se multiplier : les populations humaines ont passé la barre du milliard d’individus vers 1800, puis celle des 7 milliards en 2011. Pour autant, cette période n’a pas été exempte de variations. À titre d’exemple, si l’on regarde l’évolution de la température moyenne dans l’hémisphère nord depuis la fin du haut Moyen-âge, on peut identifier une période légèrement plus chaude entre l’an 950 et 1250 (« l’optimum médiéval ») et une période plus froide entre 1450 et 1850 (« le petit âge glaciaire »).

Mais depuis 1850, on constate une tendance claire au réchauffement climatique, et même une accélération de celui-ci. Au XXe siècle, la température moyenne du globe a augmenté d’environ 0,6°C et celle de la France métropolitaine de plus de 1°C. La décennie 2002-2011 est la période de 10 années consécutives la plus chaude au moins depuis le début des mesures instrumentales, en 1850. En raison d’une forte variabilité naturelle, la température moyenne du globe peut, certaines années, être plus élevée ou plus basse que celle des années précédentes. Mais cette variabilité interannuelle ne doit pas être confondue avec l’évolution de fond : une tendance générale à la hausse marquée depuis plus d’un siècle. Près de la surface terrestre, le réchauffement s’est accentué. Depuis le milieu des années 1970, il a atteint une moyenne de 0,17°C par décennie.

Anomalie de la température moyenne annuelle du globe entre 1850 et 2014

Si au cours du XXe siècle, la température moyenne a augmenté en France de 0,1°C par décennie, cette tendance s’est récemment accélérée. Sur la période 1951-2000, cela se traduit par une diminution du nombre de jours de gel en hiver (de l’ordre de 3 à 4 jours tous les 10 ans à Toulouse et de 4 à 5 jours à Nancy), et par une augmentation du nombre de jours où la température dépasse 25 °C en été (augmentation de 4 jours tous les 10 ans à Paris et de plus de 5 jours à Toulouse). De même, en outre-mer, le réchauffement s’accentue depuis la fin des années 1970.

Côté précipitations, l’évolution est plus contrastée. On observe une augmentation sur les deux tiers de l’Hexagone avec des contrastes saisonniers marqués : hausse des précipitations pendant l’hiver, baisse des précipitations pendant l’été et allongement des sécheresses les plus longues. Ce réchauffement global n’est pas accompagné de changements notables dans la fréquence et l’intensité des tempêtes à l’échelle de la France, ni du nombre et de l’intensité des épisodes de pluies diluviennes dans le Sud-Est.

Anomalie de la température moyenne annuelle en France entre 1900 et 2014

Le dérèglement du climat, c’est connu depuis longtemps !

Les premières suppositions sur l’effet de serre sont faites par le scientifique Jacques Fourier en 1824. Plusieurs scientifiques après lui, vont étudier et tenter de quantifier le phénomène, comme Claude Pouillet et John Tyndall. Mais la première expérience de validation et de quantification précise de l’effet de serre est faite par le scientifique Svante Arrhenius à la fin du XIXe siècle. Dans les années 1890, il découvre qu’un air riche en gaz carbonique retient plus la chaleur des rayonnements solaires, ce qui conduit à une augmentation de la température de l’air. Il en conclut que si l’on rejette dans l’atmosphère de grandes quantités de carbone (à cause des activités industrielles fonctionnant par la combustion du charbon), l’air va se charger en CO2 et retenir plus de chaleur. Les premières estimations de l’augmentation des températures faites par Arrhenius ou d’autres scientifiques de l’époque comme le géologue Thomas Chamberlin sont les suivantes : si l’on double la quantité de gaz à effet de serre dans l’atmosphère, la température moyenne augmentera de 5 degrés. En 1901, Gustaf Ekholm utilise pour la première fois, le terme « effet de serre » pour décrire le phénomène.

Pendant plusieurs décennies, ces découvertes ne sont pas prises au sérieux dans la communauté scientifique. À l’époque, beaucoup de spécialistes estiment que la nature pouvait s’auto-réguler et que l’impact de l’homme était minime. Notamment, beaucoup de scientifiques pensaient que le surplus de CO2 serait de toute façon absorbé par l’océan, ce qui est vrai, mais pas totalement. Toutefois, la thèse de la possibilité d’un réchauffement climatique lié aux gaz à effet de serre (dont le gaz carbonique) finit par être validée dans les années 1940 par Gilbert Plass. À l’aide des technologies modernes, il prouve de façon définitive que la concentration de gaz à effet de serre dans l’atmosphère influe sur la capacité de l’air à retenir les rayons infrarouges et la chaleur. Ce sont les premières définitions du réchauffement climatique.

Dans les années 60, plusieurs scientifiques vont montrer que les présomptions sur l’effet de serre s’avèrent en fait réelles. Charles David Keeling prouve par exemple que la concentration de CO2 dans l’atmosphère augmente progressivement grâce à ses mesures près d’Hawaï. Roger Revelle prouva que le carbone dégagé par la combustion d’énergies fossiles n’était pas immédiatement absorbé par l’océan. Les scientifiques commencent à se préoccuper de plus en plus du réchauffement climatique, et de ce fait, la société politique va commencer à prendre en compte ce problème.

En 1971, le premier Sommet de la Terre évoque pour la première fois dans une grande conférence internationale, la définition du réchauffement climatique et ses conséquences. En 1972, John Sawyer publie un rapport scientifique mettant en évidence de façon de plus en plus claire, les liens entre le réchauffement climatique et l’effet de serre. Pendant encore plus d’une décennie, les preuves du réchauffement climatique s’accumulent dans la communauté scientifique au point qu’au milieu des années 1980, les 7 plus grandes puissances économiques mondiales (le G7) demandent à l’ONU de créer un groupe d’experts chargés d’étudier la question. C’est la première fois qu’il y a une vraie prise en compte et une vraie définition du réchauffement climatique comme problème public par les institutions internationales.

Le GIEC : Groupe d’Experts intergouvernemental sur l’évolution du climat

Dès 1988, un Groupe d’experts intergouvernemental sur l’évolution du climat a été fondé à la suite de différents travaux consacrés à l’impact de l’activité humaine sur le changement climatique. Le GIEC a été créé par deux institutions des Nations unies : l’Organisation météorologique mondiale (OMM) et le Programme des Nations unies pour l’environnement (PNUE). Cet organisme intergouvernemental est ouvert à tous les pays membres de ces deux institutions.

Le GIEC a pour mandat d’évaluer, sans parti pris et de manière méthodique et objective, l’information scientifique, technique et socio-économique disponible en rapport avec la question du changement du climat. Ces informations sont sélectionnées parmi les études effectuées par des organismes pluridisciplinaires internationaux et publiées dans des revues scientifiques.

Le GIEC rend compte des différents points de vue et des incertitudes car, évidemment, les scientifiques ne sont pas d’accord sur tout. Il travaille surtout à dégager clairement les éléments qui relèvent d’un consensus de la communauté scientifique et à identifier les limites d’interprétation des résultats.

La compréhension des fondements scientifiques du changement climatique provoqué par l’homme doit permettre d’en établir les conséquences et d’envisager des stratégies d’adaptation et d’atténuation.

L’une des principales activités du GIEC consiste à procéder, à intervalles réguliers, à une évaluation de l’état des connaissances les plus avancées relatives au changement climatique. Pour ce faire, il produit régulièrement des rapports d’évaluation composés de plusieurs volumes : cinq ont été publiés entre 1990 et 2014. La publication du sixième rapport d’évaluation (AR6) est prévue en 2021-2022.

Le GIEC élabore aussi des rapports spéciaux et des documents techniques sur des sujets qui nécessitent des informations et des avis scientifiques indépendants. Plusieurs rapports spéciaux ont été réalisés sur des thèmes particuliers : piégeage et stockage du dioxyde de carbone, préservation de la couche d’ozone, transferts de technologies, évaluation de la vulnérabilité, utilisation des terres, aviation, méthodologie d’inventaire, scénarios d’émissions, énergies renouvelables, événements extrêmes.

Au cours de son 6e cycle (2016-2022), le GIEC produira trois rapports spéciaux : réchauffement planétaire de 1,5°C, changement climatique et terres émergées ; l’océan et la cryosphère dans le contexte du changement climatique. Le GIEC peut également publier des documents techniques, rassemblant les résultats de rapports précédents sur un sujet donné : le changement climatique et l’eau, les changements climatiques et la biodiversité, incidences des propositions de limitation des émissions de CO2.

Enfin, les experts fixent, sous la forme de rapports méthodologiques, les méthodes à appliquer pour les inventaires nationaux d’émissions de gaz à effet de serre. La production du GIEC constitue l’apport scientifique alimentant les négociations internationales sur le climat qui se déroulent sous l’égide de la convention-cadre des Nations unies sur les changements climatiques (CCNUCC) et du protocole de Kyoto.

Lors des négociations internationales, le GIEC a seulement le statut d’observateur.

Le protocole de Kyoto

Le protocole de Kyoto est un accord international visant à la réduction des émissions de gaz à effet de serre et qui vient s’ajouter à la Convention-cadre des Nations unies sur les changements climatiques dont les pays participants se rencontrent une fois par an depuis 1995.

Signé le 11 décembre 1997 lors de la 3e Conférence des parties à la convention (COP3) à Kyoto, au Japon, il est entré en vigueur le 16 février 2005.

Les pays signataires dits « de l’annexe » (les pays développés ou en transition vers une économie de marché comme la Russie) ont accepté globalement de réduire de -5,5 % leurs émissions de gaz à effet de serre sur la période 2008-2012 par rapport au niveau atteint en 1990.

Parmi ces pays, les États-Unis ont accepté une réduction de 7 %, le Japon de 6 % et l’Union européenne de 8 %. A la suite de cet engagement, l’Union européenne a estimé nécessaire de procéder à une répartition de la charge de cet objectif entre les quinze États membres. A l’horizon 2008-2012, la France a donc dû stabiliser ses émissions de gaz à effet de serre à leur niveau de 1990.

Chaque Partie doit s’engager à ne pas dépasser la quantité globale d’émissions attribuée prenant en compte les 6 gaz mentionnés (sur la base de « l’équivalent CO2 »). Toutes ont dû soumettre avant la période d’engagement 2008-2012, un rapport sur leurs émissions de GES.

Par ailleurs, le protocole de Kyoto prévoit trois mécanismes de « flexibilité » auxquels les pays développés peuvent recourir. Ces mécanismes s’ajoutent aux mesures qui peuvent être mises en place sur le plan national pour réduire les émissions de GES :

les permis d’émission, mécanisme qui permet de vendre ou d’acheter des droits à émettre des GES entre les pays industrialisés afin d’améliorer les systèmes de production les plus polluants. Les États membres fixent pour chaque période des objectifs de réduction d’émission de GES à chacune des installations concernées grâce à un Plan National d’Affectation des Quotas (PNAQ) ;

la « mise en oeuvre conjointe » (MOC), mécanisme de financement de projets ayant pour objectifs principaux le stockage de carbone et la réduction des émissions de GES. Elle concerne principalement les projets industriels et forestiers lancés en Russie et dans les pays d’Europe centrale et orientale. Entre deux pays industrialisés, elle donne la possibilité aux entreprises d’investir dans des « projets propres » en dehors de leur territoire national. Ceux-ci permettent de générer des crédits d’émission de GES utilisables par les investisseurs ;

le « mécanisme de développement propre » (MDP), mécanisme qui permet aux pays développés de réaliser leurs objectifs de réductions d’émissions de GES en investissant dans des projets réduisant les émissions de GES dans des pays en voie de développement. En retour, ils obtiennent des crédits d’émission pouvant être utilisés pour leurs propres objectifs de réduction d’émissions de GES.

Le système communautaire d’échange de quotas d’émission (SCEQE) a été initié le 1er anvier 2005 en Europe. Il s’agit du premier et du plus grand système d’échange de quotas d’émission de GES mis en place dans le monde. Il couvre actuellement plus de 11 000 installations européennes.

Durant la phase 1 (2005-2007) du SCEQE, le prix du carbone et le principe d’échange de quotas ont été définis. Durant la phase 2 (2008-2012), les quotas étaient encore gratuits mais les sanctions ont été durcies en cas de dépassement du plafonnement d’émissions autorisées. En raison de l’incapacité du SCEQE à fixer un réel signal prix du carbone, une révision a été actée en 2009 pour la phase 3 (2013-2020) avec de nombreuses modifications : plafond d’émissions unique pour l’UE (au lieu des précédents plafonds nationaux), mise aux enchères des quotas (qui doit être progressivement élargie), inclusion de nouveaux secteurs, etc.

Finalement, les États-Unis, alors plus gros émetteurs de gaz à effet de serre, ont signé ce protocole mais ne l’ont jamais ratifié.

Les pays engagés par le protocole de Kyoto ont collectivement atteint cet objectif (avec une réduction supérieure à 20 %).

Une seconde période d’engagement du protocole a été fixée lors du sommet de Doha en décembre 2012. Elle s’étend du 1er janvier 2013 au 31 décembre 2020.

Les accords de Paris sur le climat

Trois ans après l’accord de Paris, où en est-on ? Pour l’instant, pas un seul pays n’est aligné sur les objectifs fixés par l’Accord de Paris. Ces objectifs consistent à limiter le réchauffement climatique en dessous de 2°C d’ici 2100. Pour cela, la France s’est par exemple engagée à diminuer ses émissions de gaz à effet de serre de 40 % d’ici à 2030. Pour l’instant, on en est bien loin, ces émissions sont même à la hausse : 459 millions de tonnes de CO2 rejetés en 2016, 466 en 2017, soit une hausse de 1,7 %.

Selon un rapport d’ONG environnementales, cinq pays font des efforts pour atteindre les objectifs : en tête, la Suède. Sa part d’électricité issue des énergies renouvelables augmente depuis l’Accord de Paris : +3 %. En deuxième position, le Portugal, et en troisième, la France. Il est encore difficile de mesurer l’impact de la sortie des États-Unis des Accords de Paris, mais il est clair que si les États-Unis, deuxième plus gros pollueur de la planète, ne respectent pas l’accord, il sera difficile de tenir les objectifs. Néanmoins, pour prendre le contrepied de Donald Trump, certains états puissants comme New York, la Californie, ou celui de Washington se sont engagés à respecter l’Accord de Paris.

L’Affaire du siècle

La pétition qui mobilise plus de 1,9 million de signataires français. Avec le soutien de la population, quatre associations qui attaquent l’Etat en justice pour inaction contre le réchauffement climatique.

Quatre associations – la Fondation pour la Nature et l’Homme (FNH), Greenpeace France, Notre Affaire à Tous et Oxfam France – attaquent l’Etat français en justice pour qu’il respecte ses engagements contre le dérèglement climatique. Cette démarche juridique est accompagnée d’une pétition, qui a déjà mobilisé plus de 1,9 million de personnes depuis son lancement le 18 décembre.